Evolución de los Sistemas Operativos

1969: Tres programadores de los laboratorios Bell (Ken Thompson, Dennis Ritchie y Douglas MCIlroy) crean el sistema operativo UNIX, aún en tiempos de terminal y sin entornos graficos existentes.

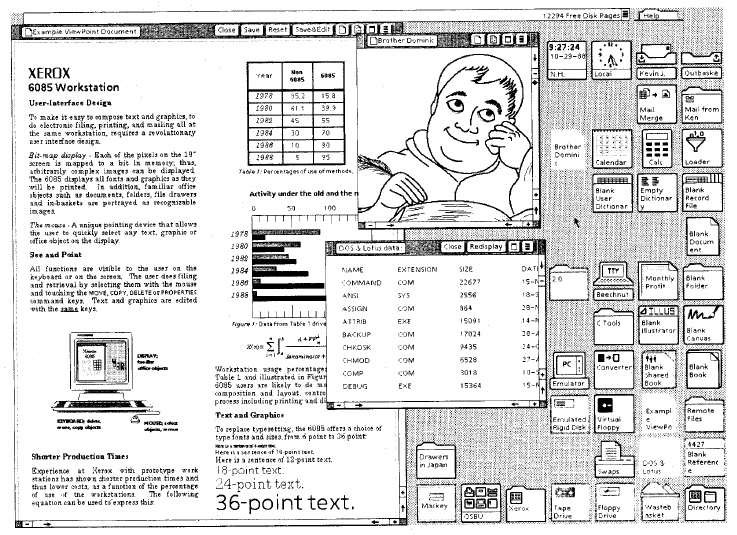

1973: Xerox crea lo que podemos llamar la “primera computadora personal mas o menos decente”, la Xerox Alto con su sistema operativo propio.

1974: Empieza la creación de BSD 1.0, que es rápidamente sucedida por BSD 2.0 en 1978.

1979: Tim Paterson crea su sistema operativo 86-DOS, que posteriormente pasó a llamarse QDOS (Quick and Dirty Operative System). Dos años después Bill Gates compra QDOS por una suma entre 25 y 50 mil dólares y rebautiza dos veces, en primer lugar como PC-DOS, el cual vende como sistema operativo a IBM para que estos lo usen en sus PCs (IBM-PC), y en segundo lugar (un año más tarde) como MS-DOS, el cual, siendo una copia casi identica a PC-DOS, vende como sistema propio (el sistema operativo sólo, en disketes).

1981: Nace Xerox Star, el sucesor de Xerox Alto.

1983: Apple muestra su primera gran obra, la Apple Lisa System 1.

1983: VisiCorp crea Visi On.

1984: Mac OS System de la mano de Apple.

1985: Microsoft Windows 1.0 ve la luz, aunque tras un grave fracaso debido a los errores que tenía, se ve rápidamente sucedido por Windows 1.01.

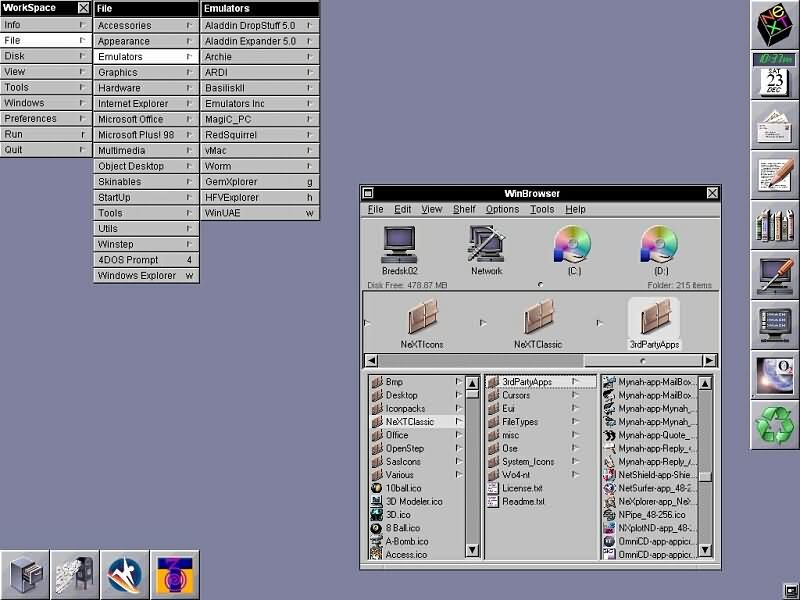

1987: Andrew S. Tanenbaum crea MINIX, un sistema operativo basado en Unix y escrito en lenguaje C, cuyo principal objetivo era el aprendizaje informático (aprender como funciona un sistema operativo por dentro). Este sistema inspiró a Linus Torvalds para la creación del Núcleo Linux. Imágen de MINIX3.

1987: Windows 2.0 aparece.

1989: NeXTSTEP / OPENSTEP

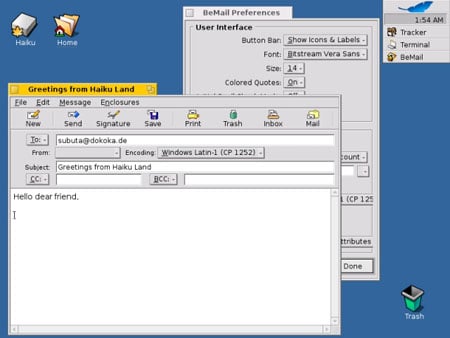

1990: BeOS de la mano de Be Incorporated. Imágen moderna.

1990: Windows 3.0. Cuya famosa actualización gratuita a 3.11 (para Windows 3.1) salió 2 años después.

1990: Richard Stallman crea el sistema GNU de software libre y el Núcleo Hurd, el cual no parece ser tan bueno para el sistema GNU como lo que Linus Torvalds crearía un año después, el Núcleo Linux. En 1992, el sistema GNU y el Núcleo Linux se unen formalmente para crear GNU/Linux, un sistema con docenas de distribuciones (“versiones” que son creadas en paralelo por diversos grupos independientes de programadores)

1995: Windows 95.

1996: IBM saca la nueva versión de su sistema operativo: OS/2 Warp 4.

1997: Mac OS System 8

1998: Windows 98.

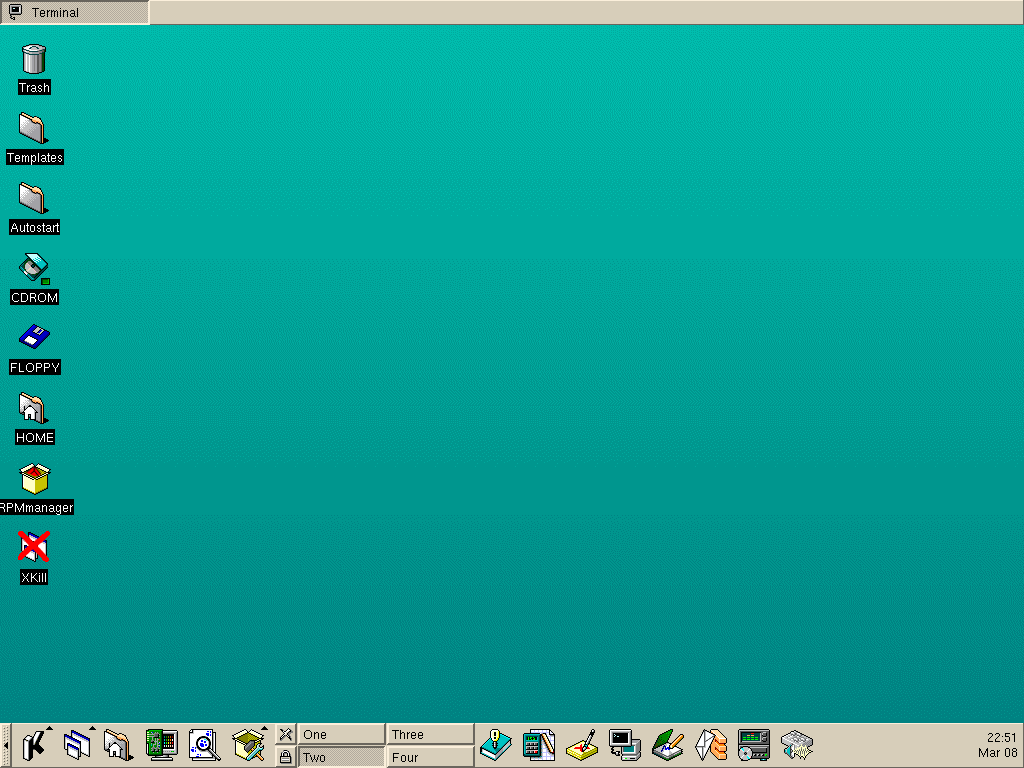

1998: GNU/Linux sigue avanzando y una de sus más famosas distribuciones, Mandrake Linux, saca su primera versión (5.1).

2001: Mac OS X.

2001: Windows XP.

2006: Ubuntu, la más famosa distribución de GNU/Linux de la actualidad, nace (en varios idiomas).

2006: Empiezan a aparecer los sistemas operativos en la Nube (Internet), como es el caso de EyeOS.

2007: Windows Vista.

2007: Mac OS X Leopard

2009: Windows 7 aparece

2011: Ubuntu saca su versión 11.04, cambiando de interfáz Gnome a Unity.